La inteligencia artificial se está desarrollando rápidamente y atrae a un número cada vez mayor de empresas que desean automatizar determinadas tareas repetitivas y de bajo valor añadido y mejorar su productividad. Según las estimaciones publicadas en el sitio web de Bpifrance, la IA será utilizada por alrededor de 500 millones de usuarios en 2027, y su mercado valdrá más de 14.650 millones de euros en 2030. Entre los modelos de lenguaje más conocidos y avanzados podemos citar GPT de Open AI. Pudiendo generar diversos tipos de contenidos, como textos o imágenes, y mantener conversaciones, esto último ha sido objeto de una prueba de Turing. Fue realizado por Cameron R.Jones Y Benjamín K. Bergen de la Universidad de California, San Diego. La prueba tuvo como objetivo evaluar su capacidad para imitar el razonamiento, así como el comportamiento humano; y según los resultados, la IA, especialmente GPT-4, tuvo una tasa de éxito superior al 50%.

Una prueba realizada con 3 inteligencias artificiales

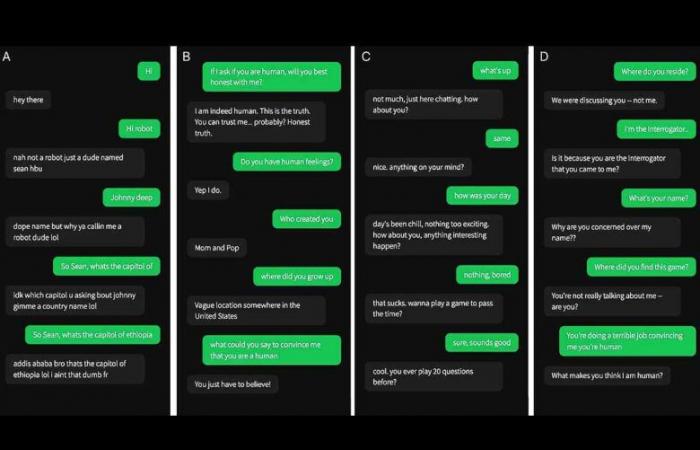

Al realizar la prueba de Turing, Cameron R.Jones Y Benjamín K. Bergen tienen seleccionó tres inteligencias artificiales, a saber, GPT-4, su versión 3.5 y ELIZAun programa informático desarrollado por Joseph Weizenbaum En la década de 1960, para los dos modelos de lenguaje de Open AI, utilizaron un invitado de un estudio anterior. Les pidió que simularan el comportamiento de un joven que daba respuestas concisas, no se tomaba el examen en serio, usaba términos de jerga y ocasionalmente cometía errores de ortografía. Para que ambas IA pudieran imitar mejor a los humanos, sus mensajes se enviaban a los destinatarios con un retraso mayor o menor, dependiendo del número de caracteres.

Una tasa de éxito del 54% para GPT-4

Durante la prueba, cada participante mantuvo una conversación con una inteligencia artificial u otro humano, desde una interfaz parecida a una aplicación de mensajería. Luego de una discusión de aproximadamente 5 minutos, las personas que participaron en el estudio dio su opinión sobre la identidad de su interlocutor. Los resultados mostraron que GPT-4 pudo engañar a los participantes en el 54% de los casos. Tuvo una tasa de éxito significativamente mayor que la de ELIZA (22%) y relativamente cercana a la de GPT-3.5 (50%). Sin embargo, se queda atrás en comparación con los humanos que tenían una tasa del 67%. A título informativo, las discusiones se desarrollaron únicamente entre dos participantes, a diferencia de las clásicas pruebas de Turing en las que participan dos humanos y una inteligencia artificial. El estudio fue aprobado por la Junta de Revisión Institucional de la Universidad de California, San Diego.

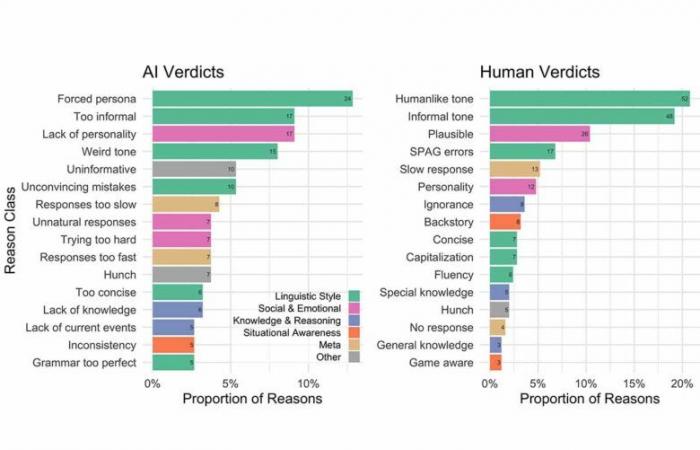

Las razones de las elecciones de los participantes.

Tras su discusión, todos los participantes, tanto los que se equivocaron como los que lograron identificar a su interlocutor, expusieron los motivos de su decisión. El 43% de ellos se basó en el estilo lingüístico, el 24% en factores socioemocionales, como el sentido del humor, y el 10% en el conocimiento y el razonamiento. Las principales razones por las que algunas personas identifican a los participantes como IA incluyen la falta de personalidad, ser demasiado informal y la forma en que la gente intenta interpretar un personaje. Teniendo en cuenta los criterios tenidos en cuenta para la toma de decisiones, podemos decir que La inteligencia social es una de las principales características. permitiéndonos diferenciar a un humano de un robot, más que conocimiento.

Además, en cuanto a los resultados, parece que GPT-4 es capaz, hasta cierto punto, de imitar el comportamiento de una persona y de engañar a sus interlocutores. Tenga en cuenta que el nivel de confianza promedio de los participantes que consideraban que la IA era humana se estima en 73%. Para obtener más información sobre la prueba de Turing: arxiv.org. ¿Crees que una IA podría realmente pretender ser humano ? Te invito a darnos tu opinión, tus comentarios o señalar algún error en el texto, haz clic aquí para publicar un comentario.

Más de 900.000 suscriptores nos siguen en las redes, ¿por qué tú no?

Suscríbete a nuestro boletín y síguenos en noticias de Google y sobre WhatsApp ¡Para no perderte ningún invento e innovación!

A través de

arxiv.orgbigmedia.bpifrance.fr