La ola de IA generativa que se ha extendido durante los últimos dos años cambia las reglas del juego en términos de ciberseguridad. Los ciberdelincuentes tienen una gran cantidad de nuevas herramientas a su disposición para mejorar sus técnicas existentes y desarrollar otras nuevas. Sin mencionar que la rápida adopción de la IA en las organizaciones crea nuevas vulnerabilidades. ICTjournal analizó la evolución de la amenaza y los medios para responder a ella con expertos de Trend Micro durante un seminario web celebrado el 4 de diciembre.

Aumentos de productividad, deepfakes e inyección rápida

El primero en tomar la palabra, el Dr. Vincenzo Ciancaglini, investigador senior de amenazas de Trend Micro, quiso desmitificar el uso de la IA por parte de los piratas informáticos, recordando que estos últimos no esperaron al boom actual para adoptar esta tecnología, por ejemplo para optimizar los intentos de descubrir contraseñas. Respecto a la IA generativa, el especialista explicó que, por el momento, no hemos observado malware sofisticado producido por IA.

Por otro lado, los piratas informáticos se han apropiado de estas herramientas para aumentar la productividad, por ejemplo para escribir correos electrónicos de phishing personalizados o depurar su código. Lo mismo se aplica a los actores estatales, que explotan la IA generativa para la ingeniería social o para la recopilación de información sobre sus objetivos.

Vincenzo Ciancaglini también se refirió al uso de deepfakes, cada vez más extendido. La tecnología se utiliza tanto contra particulares (chantaje deepnude, falso secuestro mediante deepaudio) como contra empresas, en particular con falsos interlocutores por videoconferencia para extraer dinero de un directivo, o falsos candidatos para no acceder a la red de la organización.

Sumado a esto, el creciente uso de la IA en las organizaciones las expone a nuevos ataques. Vincenzo Ciancaglini describió en particular técnicas de inyección rápida, que deslizan instrucciones o enlaces maliciosos en mensajes y otros contenidos que impulsan la IA generativa.

Maneras de defenderte

Ante la proliferación de deepfakes dirigidos a particulares, Cyrille Larrieu, ingeniero senior de preventa de Trend Micro, subrayó la importancia de los recursos humanos. Recomendó ser escéptico con su interlocutor, desafiarlo y extremar la vigilancia en cuanto surja una cuestión de dinero. También describió las herramientas técnicas disponibles para los particulares, como los detectores de deepfake en el móvil (Trend Micro Check) o en el PC (Deepfake Inspector), que alertan a los usuarios en cuanto hay indicios de contenido artificial.

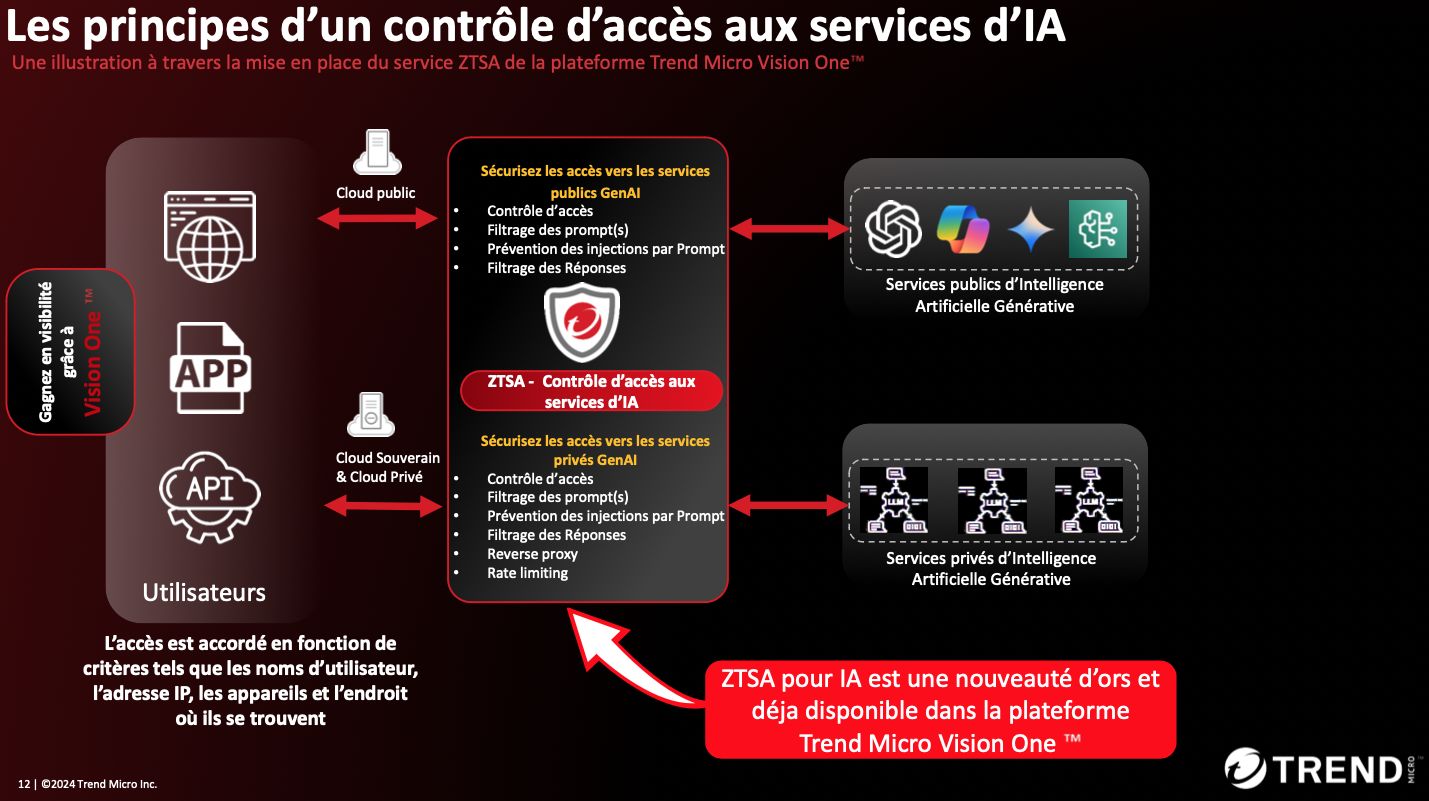

En cuanto a las organizaciones que emplean soluciones de IA generativa, Cyrille Larrieu describió cuatro riesgos: falta de visibilidad de estos usos, exposición de datos sensibles, manipulación de modelos y cumplimiento. Para el especialista, el enfoque y las arquitecturas Zero Trust permiten abordar estos riesgos, siempre que se complementen con controles adicionales. Así, por ejemplo, la plataforma Zero Trust de Trend Micro (Vision One) hoy incorpora controles de acceso a aplicaciones GenAI públicas o privadas, filtros en el lado de solicitud y en el lado de respuesta, así como técnicas de prevención de inyección, que las organizaciones pueden configurar.

El especialista también subrayó la importancia de los paneles de control y las herramientas estadísticas para monitorear el uso de la IA generativa en la organización y comunicar sobre los ataques que puedan haber sido frustrados.

Agentes GenAI y cadena de suministro

Durante la sesión de preguntas y respuestas, los especialistas de Trend Micro también discutieron los riesgos asociados con la aparición de características agentes en las soluciones de IA generativa. “El riesgo es una adopción meteórica, como experimentamos con ChatGPT, con múltiples agentes especializados que orquestar, cada uno de los cuales probablemente cometa errores o sea manipulado”, advirtió Vincenzo Ciancaglini.

El experto también destacó los riesgos relacionados con la proliferación de modelos de IA generativos (varias decenas de miles en Huggingface) y, por tanto, con el uso de agentes más o menos fiables o sutiles. Por lo tanto, un peligro para la cadena de suministro de GenAI, similar a lo que experimentamos con las bibliotecas populares de Javascript y Python.

Para obtener más información, el seminario web completo está disponible en vídeo: