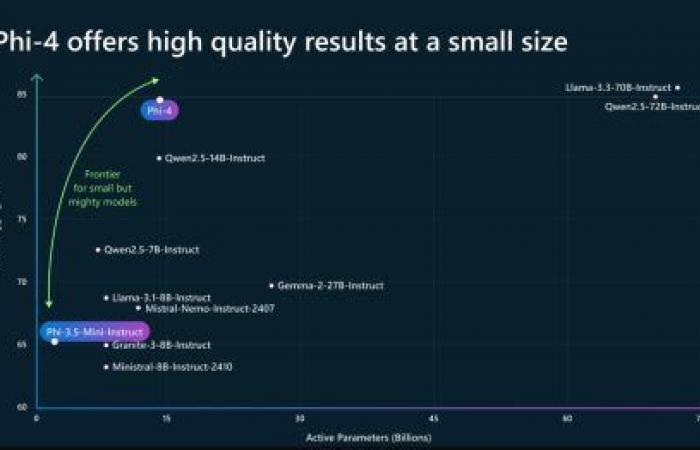

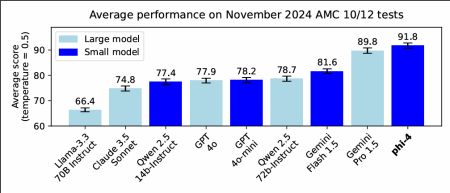

¿Qué queda todavía para los grandes modelos? En determinadas pruebas matemáticas y aritméticas, el nuevo SLM “Phi-4” de Microsoft resulta más relevante que los modelos de gran frontera GPT-4o, Claude 3.5 o Gemini Pro 1.5.

Dominado durante mucho tiempo por arquitecturas gigantescas que acumulan cientos de miles de millones de parámetros, el ecosistema de IA ahora está entusiasmado con las ventajas estratégicas de los modelos más compactos. Rápidos de entrenar, más económicos en recursos informáticos y más fáciles de implementar, estos modelos “pequeños” han sido necesarios hasta ahora en entornos restringidos, ya sean aplicaciones industriales o herramientas dedicadas a la investigación o servicios híbridos. Pero hoy en día son esenciales en todas partes, tanto en los laboratorios de investigación como en las empresas e incluso en la IA en la nube, como lo demuestra el enorme potencial de “Gemini 2.0 Flash”, ahora el modelo de referencia multimodal para el asistente Gemini AI.

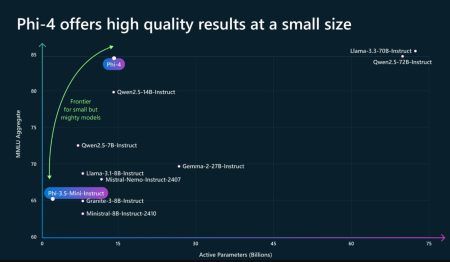

En 2024, los modelos pequeños se han multiplicado como pan caliente, acercándose y a veces superando las capacidades de los modelos grandes, al tiempo que requieren muchos menos recursos informáticos y energéticos para inferirlas, o incluso siendo capaces de ejecutar localmente una IA igualmente talentosa que los principales modelos de nube, siempre y cuando se usan sabiamente.

Entre estos pequeños modelos, el rango phi de Microsoft ha aparecido mucho en las noticias este año. Las primeras versiones de Phi fueron adoptadas por equipos de investigación, desarrolladores independientes y empresas tecnológicas deseosas de encontrar un compromiso óptimo entre rendimiento, velocidad y coste. Las iteraciones anteriores, como Phi-3, demostraron la capacidad de mantener una calidad de respuesta satisfactoria al tiempo que limitaban el tamaño de la red neuronal. Los usuarios vieron esto como una oportunidad para integrar más fácilmente la IA en sus productos y servicios, sin la pesada infraestructura y los costos de energía asociados con los gigantes del campo.

Phi-4, un modelo pequeño que razona

Es en este contexto que Microsoft acaba de anunciar fi-4una nueva generación que se distingue por Avances significativos, particularmente en el campo de las matemáticas.. Los LLM de gran frontera como “Open AI o1” o “Anthropic Sonnet 3.5” apenas han introducido capacidades de razonamiento cuando dichas capacidades ya están comenzando a caer en el mundo de los modelos pequeños.

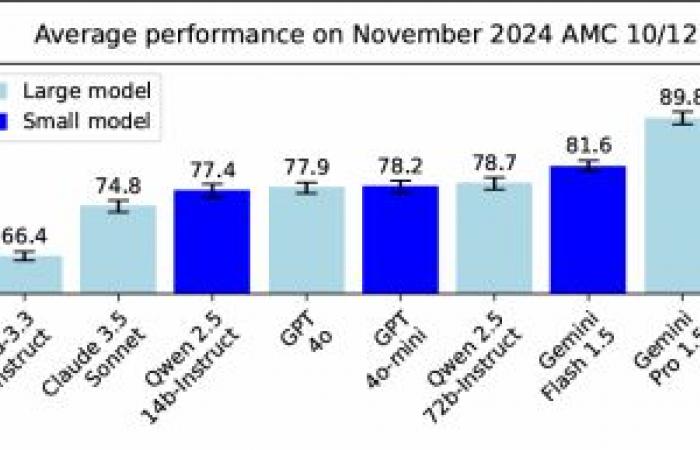

Con 14 mil millones de parámetrosPhi-4 sigue siendo un modelo de tamaño “modesto” según los estándares del mercado, pero alcanza un nivel notable de rendimiento en evaluaciones exigentes, superando incluso a modelos más grandes, incluidos Gemini 1.5 o Claude 3.5 Sonnet, en la resolución de problemas matemáticos.

Este éxito depende de la calidad del conjunto de capacitación cuidadosamente elegido, la implementación de una limpieza de datos más estricta, un cuidadoso proceso posterior a la capacitación (por ejemplo, mediante técnicas de muestreo de rechazo, autorrevisión, inversión de instrucciones), todo para garantizar la credibilidad. de las evaluaciones y la relevancia de los resultados. Además, se hizo un esfuerzo particular para evitar el riesgo de contaminación de las pruebas de rendimiento por datos ya observados durante la fase de aprendizaje. Esta precaución resulta crucial para autentificar la mejora real de las capacidades del modelo, confirmada por pruebas matemáticas recientes e inéditas.

El resultado es un modelo Phi-4 mejor entrenado y más nítido, y Capaz de abordar problemas aritméticos y algebraicos con mayor confianza y coherencia..

El resultado es un modelo Phi-4 mejor entrenado y más nítido, y Capaz de abordar problemas aritméticos y algebraicos con mayor confianza y coherencia..

Evidentemente, el modesto tamaño de Phi-4 sigue siendo un obstáculo para ciertas formas de razonamiento en profundidad o de comprensión contextual, y el modelo no escapa al conocido fenómeno de las “alucinaciones” cuando el dominio abordado es demasiado específico o está insuficientemente representado en el corpus de entrenamiento.

Por ahora, Phi-4 está disponible a través de la plataforma Azure AI Foundry, bajo una licencia de investigación, y pronto debería unirse a otros canales de distribución, incluido Hugging Face. Su disponibilidad forma parte de un esfuerzo destinado a democratizar modelos de tamaño más razonable, más sencillos de personalizar y mejor adaptados a diversos contextos operativos. Sin duda, todavía oiremos mucho sobre modelos pequeños en 2025…

Fuente: Presentación de Phi-4: el modelo de lenguaje pequeño más nuevo de Microsoft que se especializa en razonamiento complejo

Lea también:

Google Gemini 2.0: La era de los agentes inteligentes

Con Phi-3, Microsoft mejora aún más sus modelos Gen AI de bolsillo

Cariño, encogí GPT-4o…

Los modelos de IA de código abierto se aceleran