Un análisis reciente de Unidad 42de Redes de Palo Altoreveló que los modelos de lenguaje como ChatGPT se puede utilizar para modificar malware en JavaScript, haciéndolo más difícil de detectar. Aunque estos modelos no generan malware desde cero, Los ciberdelincuentes pueden pedirles que reescriban u ofusquen el código malicioso existente.. “Estas transformaciones son más naturales, lo que dificulta la identificación del malware”, afirman los expertos en ciberseguridad. Este enfoque podría degradar los sistemas de clasificación de malware al confundiéndolos para que etiqueten el código malicioso como inofensivo.

Suscríbete a la Newsletter de Softonic y recibe las últimas novedades en tecnología, juegos y entretenimiento en tu bandeja de entrada

Suscríbete (es GRATIS) ►

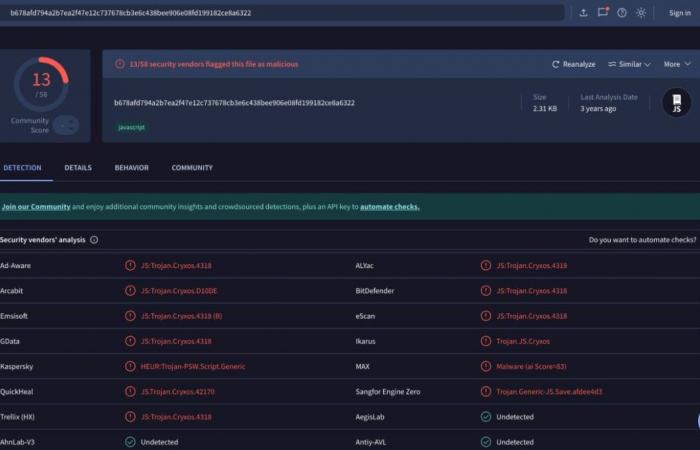

A pesar de las restricciones de seguridad impuestas por proveedores como AbiertoAIherramientas como GusanoGPT se utilizan para crear correos electrónicos de phishing más convincentes y nuevos tipos de malware. En octubre de 2024, OpenAI bloqueó más de 20 redes maliciosas que buscaban explotar su plataforma. En las pruebas, la Unidad 42 logró generar 10.000 variantes maliciosas de JavaScript, manteniendo su funcionalidad pero disminuyendo sus puntuaciones de detección en modelos como Inocente hasta que se demuestre lo contrario. Las técnicas utilizadas incluyen cambiar nombres de variables, insertar código innecesario y reescribir completamente el script.

Además, Se puede engañar a los algoritmos de aprendizaje automático para que clasifiquen estas variantes como benignas en el 88% de los casos.según la Unidad 42. Incluso las herramientas más populares, como VirusTotal, tienen dificultades para detectar estos códigos. Los investigadores advierten que estas reescrituras impulsadas por IA son más difíciles de rastrear que las generadas por bibliotecas como obfuscator.io. Sin embargo, sugieren que estas mismas técnicas podrían mejorar los modelos de detección al generar datos de entrenamiento más sólidos.

En otro frente, investigadores delUniversidad Estatal de Carolina del Norte descubrió un ataque llamado TPUXtractoque te permite robar modelos de IA que se ejecutan en TPU Borde de Google mediante señales electromagnéticas. Dicho esto, aunque la técnica destaca por su precisión, Requiere acceso físico al dispositivo y equipo especializado.lo que afortunadamente limita su alcance.

Además, Morfisec demostró que el sistema Sistema de puntuación de predicción de exploits (EPSS)utilizado para evaluar vulnerabilidades, puede manipularse con publicaciones falsas en redes sociales y repositorios de GitHub vacíos. De acuerdo a Ido Ikaresta técnica permite “inflar indicadores” y engañar a las organizaciones cambiando las prioridades de gestión del riesgo cibernético.

Business